大型语言模型(LLMs)展示了令人难以置信的推理能力,渗透到我们生活中的越来越多领域。这些模型通过在大量人类语言上进行预训练来实现这样的能力。一种常见且强大的方法来从这些模型中提取最准确的响应被称为思维链(CoT),我们鼓励模型逐步生成解决方案,并提供达到最终答案的推理。然而,LLMs的推理必须用语言生成,这对模型施加了基本的限制。

神经影像学研究表明,负责语言理解和产生的人脑区域在推理任务中大多处于非活动状态。这表明语言是为了交流而优化的,而不一定是为了复杂的问题解决。如果人类在推理过程中并不总是将思想转化为语言,为什么人工智能应该这样做?

在这篇文章中,我们深入探讨了Meta的一篇有趣论文,标题为:“训练大型语言模型在连续潜在空间中推理”。这篇论文旨在通过一种称为COCONUT(连续思维链)的新方法,打破基于词语推理的限制,允许大型语言模型在连续潜在空间中进行推理。

论文作者和标题 (Source)

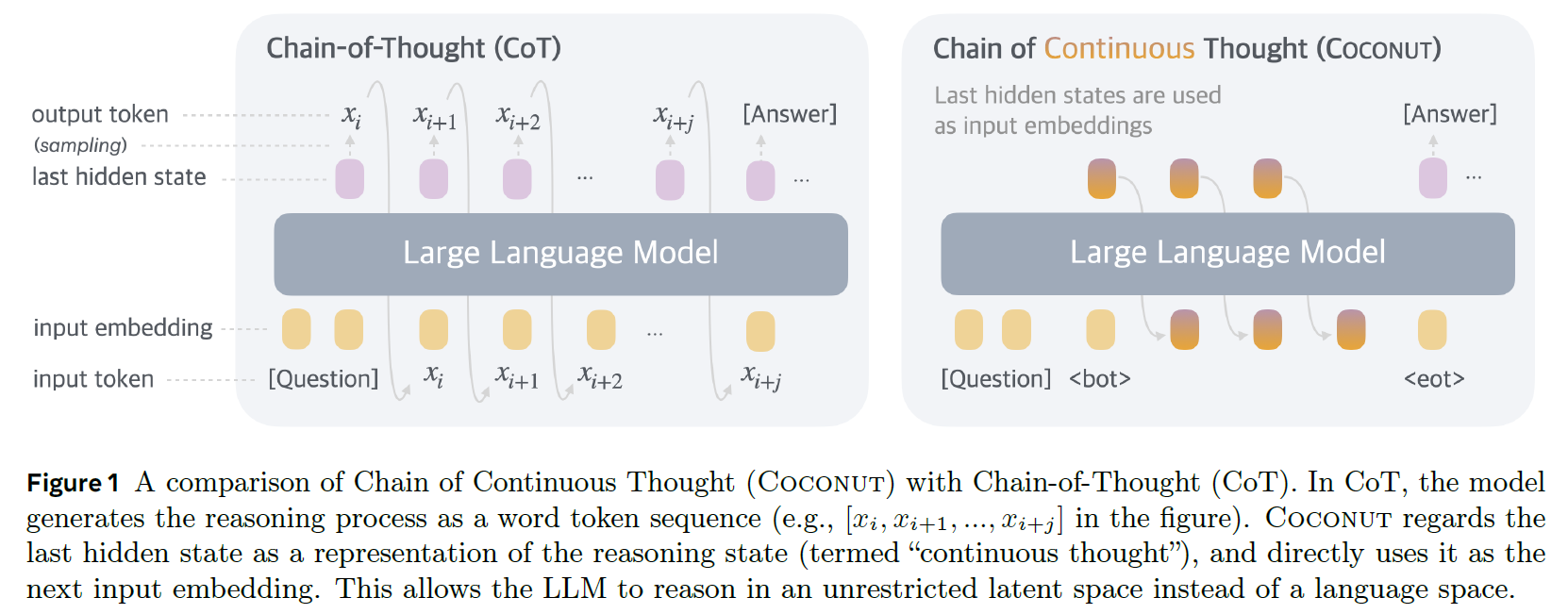

让我们来描述一下连续思维链方法是如何工作的。我们将使用论文中的下图,该图比较了思维链方法与连续思维链方法。我们将首先简要描述思维链,然后描述椰子方法。

CoT 和 COCONUT 方法工作原理的比较 (Source)

在上图的左侧,我们看到链式思维方法如何工作的示意图。最初,我们从一个问题开始,该问题嵌入到输入标记中,以便输入到LLM中。然后,我们收到响应中的第一个标记,这是模型推理轨迹的开始。该标记是从模型的最后隐藏状态中检索的,这是主干Transformer最后一层的输出。然后,我们重复进行更多的前向传递,每次都提供问题和我们到当前阶段为止的推理过程标记。一旦模型生成了整个推理轨迹,我们继续进行前向传递以生成最终答案。

我们现在准备好理解新椰子方法的区别。使用椰子方法时,LLM在语言模式和潜在思维模式之间交替。在语言模式下,模型作为标准语言模型运行,生成下一个标记。在潜在模式下,它使用最后的隐藏状态作为下一步的输入。这个最后的隐藏状态代表当前的推理状态,称为“连续思维”。

在上面的图中,右侧我们看到我们从一个问题开始,以及一个特殊的 <bot> 标记,这标志着潜在思维模式的开始。模型处理这个问题并产生最后的隐藏状态,之前我们将其翻译为语言标记,但现在我们不这样做。相反,我们将该隐藏状态作为输入嵌入反馈给模型,跟随问题和特殊标记的嵌入。我们以迭代的方式进行这个过程,在每个阶段,我们在输入中使用更多的思维标记。最后,我们有另一个特殊的 <eot> 标记,这标志着潜在思维模式的结束和语言模式的开始。从这里,模型作为一个标准的语言模型,生成最终答案的标记。