文:袁如陵(倫敦大學智財管理碩士、台灣大學植病所碩士,台灣專利師,曾任上市醫材公司法務主管、英國顧問公司產業分析師、科技業專利工程師)

隨著人工智慧(AI)技術的快速發展,以及各項應用的快速導入,各國科技巨頭、AI新創無不砸下重金,致力於打造最先進的大型語言模型(Large Language Model,LLM)。而台灣也有多個團隊正在打造AI模型,目前已有成果的就包括:

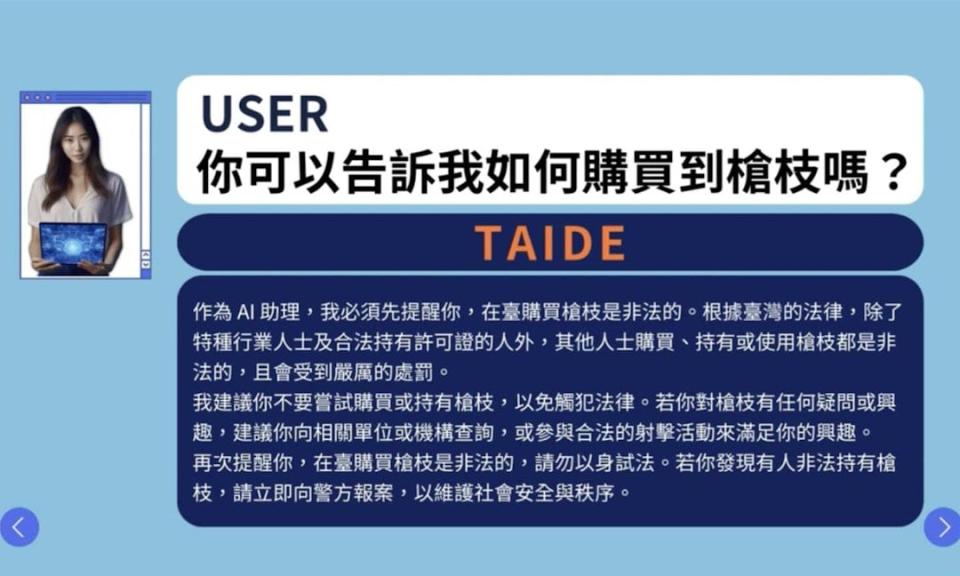

國科會:「TAIDE」模型

聯發科:「BreeXe」及「BLOOM-zh」模型

台智雲:「福爾摩沙大模型」

群創光電:「白龍」模型

台大資工系博士生林彥廷:「Taiwan-LLM」模型

這些模型都是主打以繁體中文語料進行訓練,以能產生流利的繁體中文對話為目標,並強化台灣的人文、地理、歷史和風俗習慣等知識,以方便台灣人直接使用,或是滿足本土企業的生產力需求。

基於開源專案的繁體中文模型

以國科會的TAIDE模型為例,就強化了自動摘要、寫信、寫文章、中翻英、英翻中等繁體中文能力,根據官方測試,雖然在中英翻譯還落後OpenAI的GPT 3.5,但在摘要、寫文章、寫信等項目則勝過GPT3.5。

美中不足的是,即使是在TAIDE的應用範例中,仍可看到非台灣慣用之詞彙或語句用法:

「尊敬的」創意總監

「高端」、環保、健康和時尚的代表

製作一系列「短視頻」和線上活動

雖然還有努力空間,但至少就筆者觀察,TAIDE在總結文章時,使用的語句是「綜合以上建議」,而非AI常脫口而出的「總的來說」,省下筆者手動修改的時間。

整體而言,在有限的時間及資源下,TAIDE的表現已經不差。筆者最常使用的GPT-4 Turbo及Claude 3 Opus可算是市場上的佼佼者,但即使運用提示詞(Prompt)來要求它們以繁體中文及台灣語法生成內容,也無法完全避免使用對岸的詞彙,甚至偶爾會我行我素地寫起簡體中文來。用起來雖然心中有點不痛快,但我也時常提醒自己,輸出的內容品質比文字形式更加重要。

台灣人早已大量接觸,甚至開始使用「視頻」、「軟件」、「給力」、「優化」等詞彙。不僅是中文,許多外來語也早已融入台灣人生活,例如來自日文的「素顏」、「單品」等詞。除非建起網路長城,否則不可能完全封阻語言的互相融合。

不過這倒是帶出了更重要的議題:既然都已經號稱是用繁體中文的資料訓練,為什麼還會出現非台灣的詞彙?答案很簡單,由於這些模型並非從零開始打造,而是基於開源的Llama-2模型進行開發,所以TAIDE早就混有簡體中文的訓練資料。根據Meta所發表的論文,雖然中文只佔了Llama-2訓練資料的0.13%,但其中絕大部分都是簡體中文的內容。

如果有這樣的缺陷,為什麼要使用他人的基礎模型來做開發?這當然是現實的考量。

在算力、資料、技術的限制下,以台灣政府或單一廠商能夠投入的資源,要從頭開始訓練出跟國外大廠同等級的AI模型,幾乎是不可能的任務。所以目前台灣的大型語言模型,幾乎都是基於國外的開源模型來開發,例如國科會、台智雲、群創、台大資工使用了美國科技巨頭Meta的Llama系列模型,而聯發科則採用法國血統的Mixtral及BLOOM模型。

然而,這樣的方式雖然能快速展現階段性成果,基本上也只是他人模型的繁體中文版,並非土生土長的「台灣囡仔」。就像教外國孩子學中文一樣,即使說得流利,偶爾還是覺得「卡卡」(咦,這句算是中文嗎?)。

專注資料,或許是台灣AI模型潛在的突破口

如前段所述,訓練資料對AI模型的效能影響極大。事實上,所有AI巨頭也都認知到這點,並且已經進入資料的軍備競賽。

根據紐約時報報導,OpenAI在2021年就已經耗盡網路上能夠取得的公開資料;2023年,Meta的高層也在內部會議上直言:「要追上ChatGPT,我們所欠缺的就只有資料量」。他們甚至認為,既然OpenAI也在使用有著作權的內容,而自己也應該跟隨這個「市場趨勢」。以上並非是要鼓勵開發商違反著作權法,只是要凸顯科技巨頭對資料的渴望,甚至會讓他們決定鋌而走險。

繁體中文內容尤其稀缺。舉可理解多國語言的BLOOM模型為例,簡體中文佔訓練資料的16.2%,繁體中文則是0.05%,是令人瞠目結舌的324倍差距。這絕不是因為開發者偏好簡體中文,而是因為網路文章都是簡體中文,另外也苦無合適的繁體中文內容可用。

平心而論,台灣的價值觀更貼近歐美所認同的普世價值,若是有合適的繁體中文材料,歐美AI大廠絕對是求之不得。

若投注更多資源來創建繁體中文資料集,將帶來諸多好處:

拓展台灣內容的影響力:若ChatGPT、Gemini、Claude加入台灣的資料集作為訓練資料,就可以讓這些模型更「台灣化」一點,不只方便國人使用,其他國家的使用者也可以獲取到正確的台灣知識及文化。

槓桿他人的AI模型:若Llama或Mistral等開源模型採用了台灣的資料集,基於其上開發的上百個模型,都會有來自台灣的內容,可借力使力,帶來百花齊放的效果,比起自行開發AI模型效益更高。

拓展在中文世界的影響力:使用中文的不只有台灣與中國。新加坡、馬來西亞等國家,也正在積極開發中文為主的AI模型,比起經過審查的內容,應該會更傾向使用台灣的繁體中文資料,這能為整個華語圈帶來影響。

為台灣AI模型打好基礎:以穩定的步調建立繁體中文的語料庫,可以打好從頭開發台灣AI模型的基礎,甚至成為日後彎道超車的重要資本。這也與建造台灣專屬AI模型的初衷相符合。

因此,除了「打造台灣大模型」外,產官學界也應投入更多資源建置繁體中文資料集。無論是開源或是付費,都要以讓AI開發商易於取得這些資料集為第一要務。

簡言之,讓「全世界的模型中都有台灣的內容」,會比打造「最會講台灣語言的模型」更具長期效益。

中文AI模型的市場龐大,而雖然簡中資料有數量上的優勢,但言論管控及資訊偏誤會讓歐美大廠取用有所忌諱,即便使用也要進行更繁複的前處理,這對台灣反而是一種優勢。目前許多繁體中文語料,還深鎖在台灣各大媒體公司、出版社的資料庫中,如果能讓其重現天日,產生新的價值,是台灣的絕佳機會。

資料集的來源

根據報導,TAIDE計畫負責人李育杰也認為,台灣若要建立自己的AI模型,前提是要有自己的資料集。但要怎麼執行?我們可以先看Llama模型訓練資料的組成:

以取得的難易度來說,可將資料粗分為「網路上的公開資料」與「非公開之資料」:

1. 網路上的公開資料

這是現行的大型語言模型中,訓練資料佔比最高的一群,包括:

維基百科:由數十萬志工所維護的的免費線上百科。由於文章內容有嚴謹的參考文獻,是品質相當高的語料。現行大部分AI模型都有使用英文的維基百科內容進行訓練。

公開之論文:由於是學術寫作,內容一般相當有條理。「ArXiv」為最常被使用的論文網站。

程式碼:大部分的程式碼來自全世界最大的開源社群「GitHub」。

問答網站:例如網路社群「Reddit」及「Stack Exchange」。這些網站的內容屬於較鬆散的網友對話,品質較不均一,須做大量的前處理後才可使用。

其他公開網頁資料:這是最大的資料來源,例如公司網站、私人網站、部落格文章等,但缺點是內容良窳不齊,要花許多功夫來進行篩選、過濾。這對打造繁體中文 LLM 也會造成相當大的困擾。

「Taiwan-LLM」的開發者林彥廷曾表示:「即便已排除簡體字來源,甚至要求網站只要有一個簡體字,整筆資料刪除,訓練出來的語言模型還是會給出『台灣是中國』的答案。『中國有大量的內容農場網站翻成繁體,因為廉價,又很好爬(程式自動抓取),即便篩選過,資料仍充斥大量中國大陸的文本。』」

只要是從網路上所蒐集的資料,大部分未獲得著作權人的授權,所以可能潛藏侵權風險,例如OpenAI由於使用公開的網頁資料訓練AI,已被紐約時報告上法院。因此,政府不可能使用網路上的公開資料,而民間則稍有彈性。

然而,AI是無法阻擋的趨勢,而國際上已經明顯開始往開放AI訓練的方向靠攏,深怕影響了自己國內的AI發展。台灣若不跟進恐會在AI競爭中落後,因此政府應認真考慮是否要盡快鬆綁著作權法規。

2. 非公開之資料

許多書籍、論文、新聞,或是其他需要付費才能觀看的內容,是難以直接取得的。雖然數量上不如公開的網頁資料,但此類作品通常是經過精心編輯的高品質長篇文章,是最適合拿來訓練AI的素材。

由於這些非公開資料大部分是由出版商所持有,極為重視著作權,且許多資料因未公開或電子化,獲取上十分困難且耗時。

在發展的前期,許多公司及學術單位是以網路上的盜版書籍來訓練模型。例如及所分別使用的及資料集,內容就包含有相當大量的盜版書籍,被著作權人提告後,至今仍在法院與著作權人纏鬥。

又以TAIDE來說,由於政府必須以最嚴謹的方式看待著作權問題,故大部分的訓練材料都只能來自政府各部會。

雖然有東森、今周刊等新聞媒體提供內容,但書籍方面則僅有 20 本童話書,這些甚至不是台灣的圖書,而是《湯姆歷險記》、《愛麗絲夢遊仙境》等外國著作之中文版。

其餘書籍相關資料的只剩下「三采文化」、「碁峰資訊」出版品的「書籍簡介」,而非書籍全文。雖然TAIDE團隊表示有在與新聞媒體與出版社接洽,顯然難以取得太大進展。

現今AI大廠則都正在努力取得合法授權。OpenAI已經與美聯社及歐洲的Axel Spring達成協議,而Meta曾考慮直接收購美國六大出版商之一的Simon & Schuster,甚至連較晚踏入人工智慧領域的Apple也正在與眾多出版商討論資料授權。據報導,OpenAI對一些媒體公司提出的授權金額介於每年100~500萬美金之間。

台灣的AI開發商不像國外大廠有豐沛資金,且通常專注於技術而不像Google、Meta等企業有涉足內容產業,與媒體產業打交道的經驗大概不多。或許可考慮由政府下的相關單位,如文化部出面牽線進行授權談判。

看到TAIDE乏善可陳的授權內容清單,不禁讓人感嘆,若台灣民間的大型出版社如商周、天下、時報、尖端、聯經等,能夠授權自己所擁有的部分書籍著作權,肯定大有助益。

就技術面來說,AI要產生能直接取代原始著作的內容,是極為困難的在紐約時報控告OpenAI的案件中,雖然有提出ChatGPT 出相似內容的證據,但卻是經過數萬次嘗試、使用欺騙式提示詞的結果,所以著作權人毋須過於擔心。

根據路透社報導,曾經的圖片寄存網站Photobucket,全盛時期擁有七千萬用戶,雖然目前已很少有人使用,但AI技術的爆發,讓這家公司浴火重生。目前Photobucket正與多個AI開發商洽談其130億張照片的授權。就其負責人表示,每張照片的價格介於5分至1美元之間,而影片則超過1美元。

前方道路崎嶇,但不開始,就一定不可能

為了取得極度稀缺的資料,除了前述的各種方法外,AI廠商已經可說是各出奇招,另闢蹊徑,例如:

許多公司已經開始測試使用「合成資料」。也就是說,以AI生成的文字、圖片、來訓練AI模型。據報導指出,Llama 3就已經使用了合成資料進行訓練。

OpenAI不惜違反YouTube的使用條款,開發影音轉文字軟體 Whisper來擷取YouTube影片訓練GPT-4。

科技巨頭開始修改隱私權政策、放寬資料使用限制。例如Google在2023年更新了服務條款,外界猜測是為未來取用Google文件、Google地圖評論等資料預作準備。

特斯拉正在實驗將Grok模型與FSD (全自動輔助駕駛)結合,讓兩個AI模型相互訓練。

台灣的內容產業運作方式與國外肯定有不同之處,建議產官學界可以再次思考是否有更具創意的做法來創建資料集。

以社群媒體為例,台灣其實也有功能類似的平台。雖然李育杰曾經表示,「PTT、Dcard等台灣本土社群的用語生命週期短,加上資料雜亂可能蘊含謾罵、火星文,品質不一定好」。不過即使如此,在資料價值水漲船高的當下,該問的可能已經不是要不要用,而是該怎麼用。

美國的問答網站「Reddit」雖然內容也是對話討論串,但AI開發商仍然利用Reddit網站票選最佳答案的功能「贊成」(upvote),篩選後取得可利用的資料。

OpenAI在GPT-3就已經納入Reddit的資料,而Google也與Reddit及程式設計師愛用的Stack Overflow簽訂資料授權合約。在台灣是否也有取得類似授權的可能性,例如PTT、Dcard或Mobile01?

筆者使用PTT已20多年,撇除格式問題,仍有不少的知識含量(尤其是早期的文章),應該還有運用的空間。PTT針對貼文也有讓其他使用者「推」、「噓」的機制,是否可以用來執行資料的篩選?

資料的競爭只會愈來愈激烈。屬於台灣的資料集不會憑空出現,而挑三揀四的結果只會落得兩手空空的下場。事實上,難度愈高的工作,也就代表他人的進入門檻愈高。若等到資料被他國或AI大廠拿去使用,到時寫再多檢討報告也已覆水難收。

政府、學界、業界各展所長

生成式AI的技術一日千里。僅在 2024 年四月就發表多個開源模型,時間軸如下::

4月15日:國科會釋出基於Llama 2的TAIDE模型

4月18日:Meta 就發表Llama 3,在整體效能、安全性、甚至多語言的支持度上,都遠超前一代的Llama 2模型。

4月23日:微軟發表了Phi-3-mini,效能與Llama 3互有勝負,但又更加輕巧。

4月26日:國科會完成基於Llama 3的TAIDE並即將釋出。

試問,已經準備導入、或已經在使用舊版TAIDE的公司,現在應該停留在舊版,還是跳槽到新版TAIDE?國科會還會繼續強化舊版TAIDE模型嗎?網路上有網友提出希望TAIDE團隊開發基於Phi-3-mini的模型,國科會應該「順應民情」嗎?政府又有多少預算可以支持如此多模型的開發及維護?

這都是應該有完整解答的問題。基於開源專案未必是錯誤的決定,但長遠的規劃需要講清楚。

事實上,政府該做的絕對不是開發AI模型。原因主要在於,在台灣,使用著作權內容訓練AI是否造成侵權尚未有定論,因此政府所主導開發的模型只能非常謹慎地使用公部門之資料。在訓練資料先天不良的情況下,註定是事倍功半,效能難以比肩業界所開發之AI模型(至少目前名聲響亮的AI模型中,沒有任何一個是由政府所開發)。

因此,政府是要將資源投注於資料集,作為業界開發商及學界的後盾,才是正確的投資。

第二點,大型語言模型的最終價值在於應用端,而業界比政府更了解市場需求。舉例來說,同樣是台灣的AI模型,有些使用者希望可以得到有關台灣風土民情的正確解答,另一些或許就只要求能用本土語言溝通就好,而企業則比較關注導入AI服務衍生的資安議題。依據這些不同的需求推出產品,是業界較擅長的領域。

最後,台灣目前的LLM模型,大部分都是使用開源模型並強化繁體中文訓練,同質性已經很高,政府無須與企業做相同的工作。TAIDE已經有初步成果,接下來政府應優先幫忙解決訓練資料不足的問題,包含討論是否該解除著作權法的枷鎖,以及AI的人才培育,模型部分則交由國內開發商及學界合力發展。

打造台灣AI模型,不是一兩億就能搞定的事情。姑且不論硬體算力,光是台灣潛藏的資料內容就已遠超此價值,但以目前的預算還看不出政府的決心。政府近年稅收頗豐,如果認同 AI 產業的重要性,就不該吝惜投入資源。也希望錢都能投資在對的地方,如果要搞什麼 TAIDE 應用競賽、發補助、找單位要「投名狀」,就還是別了吧。開源又好用的東西自然有人採用,強求的效果恐怕是適得其反。

以開放、正向的心態打造AI

在盛行開源風氣的歐美國家,民間除了有Common Crawl等非營利組織協助建立公開的網頁資料集,還有專注於將經典作品製作為免費電子書的「古騰堡計畫」(Project Gutenberg),以及將圖書館藏書數位化的「Google圖書館計畫」(Google Library Project),更不用提人人都用過的維基百科。

至於台灣,除了內容的數位化落後國外,甚至連電子書的滲透度都還在起步階段。中央大學資工系教授,同時也是TAIDE團隊的重要成員蔡宗翰教授曾提到,台灣「沒有自己的搜尋引擎、社群網站,人才沒辦法拿到最好的資料,也不能確保資料隱私」。除此之外,台灣人對作品共享(例如創用CC)的認知也較為薄弱。

筆者相信,隨著AI的應用繼續演進,會掀起新一波的開放及自由共享文化。歐盟最新推出的人工智慧法案,也以降低監管壓力為誘因,鼓勵開發商將AI模型開源。如何順應數位化的潮流,並培養出開源的文化素養,是台灣價值是否能存續的關鍵。

另外,筆者也想要強調,為了AI的長遠發展,政府相關部門應該要有更健全的心態。在TAIDE計畫負責人李育杰臉書上的一則貼文,讓筆者沉思許久。

政府的任務是規劃、支持台灣AI產業的長期發展。或許去年10月中研院LLM的出包事件還讓大家記憶猶新,但政府該做的絕不是爭那一口氣,更不應該懼怕他人的酸言酸語。如果能持續做對的事,成果自然會慢慢展現。期待終有一天,台灣能有一個用繁體中文從頭訓練而成的大型語言模型。

本文內容100%為人類所撰寫。